Einfache Neuronale Netze zum nicht-überwachten Lernen von Mustern haben Probleme, wenn die Unterschiede in den zu lernenden Mustern sehr gering sind. Im Rahmen meiner Doktorarbeit habe ich u.a. untersucht, wie sich dies mit Hilfe zusätzlicher hemmender Rückwerts-Verbindungen verbessern lässt (Michler, F., Wachtler, T., Eckhorn, R., 2006).

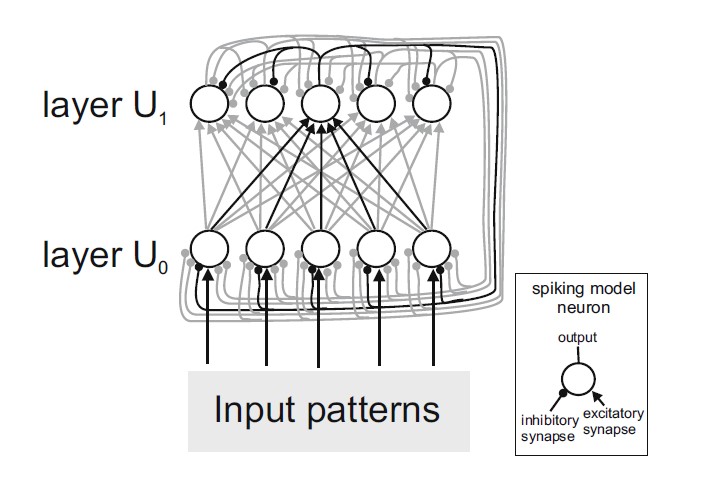

Eine aus der Biologie inspirierte Architektur für Netzwerke zur Muster-Erkennung hat folgende zwei wichtige Bestandteile:

- erregende (exzitatorische) Vorwärts-Verbindungen, die durch einen Lern-Algorithmus (Hebb’sches Lernen, STDP) angepasst werden können,

- sowie hemmende (inhibitorische) laterale Verbindungen, welche eine Konkurrenz zwischen den Output-Neuronen hervorrufen.

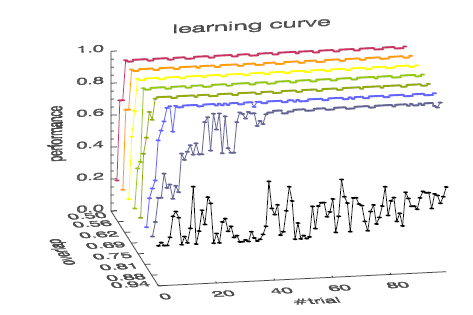

In dieser Arbeit habe ich untersucht, wie mit zusätzlichen hemmenden Verbindungen die Fähigkeit des Netzwerkes verbessert werden kann, auch sehr ähnliche Muster zu unterscheiden.

Ich konnte zeigen, dass dies tatsächlich sowohl die Lerngeschwindigkeit als auch die Unterscheidungsfähigkeit des Netzwerkes verbessert.

Als Modellneuronen kamen sogenannte impulskodierende („spikende“) Neuronen zum Einsatz. Daraus ergibt sich u.a. die Frage, ob und wenn ja wie sich das Konzept auf Netzwerke übertragen lässt, deren Modellneuronen keine Aktionspotentiale erzeugen sondern einen kontinuierlichen Ausgabewert (interpretiert als die Spike-Frequenz ) haben. Solche Modellneuronen kommen z.B. in „Convolutional Neural Networks“ (CNNs) sowie in den aktuell so populären Transformer-Netzwerken (große Sprachmodelle, „LLMs“) zum Einsatz.